AI模特目前绝大部分应用还在静态图片上,用于生成服装效果图,但是在未来,ai模特一定会变得更高级,更强大,满足更多的需求——目前行业发展和需求较多的存在下面方向:

复杂场景与AI模特贴合:

ai模特身处亚马逊雨林

动态视频与直播间:

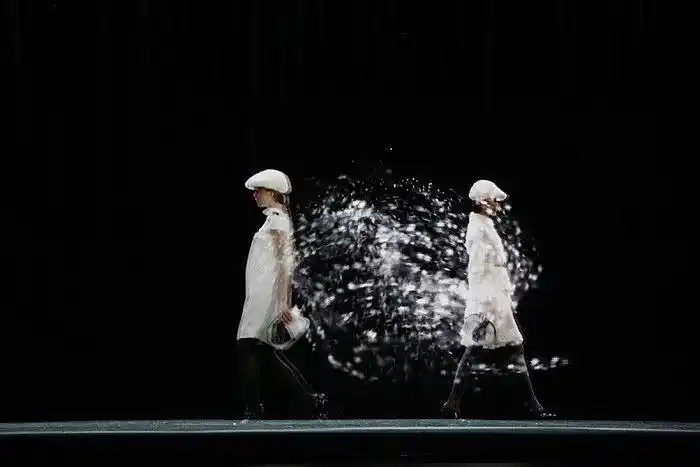

全息走秀:

全息模特时装走秀

我们来挨个看看升级的意义和要点,以及技术方向:

复杂场景:提升品牌档次与科技感,场景无限

Ai模特上古冰川时代图

模特可以出现在任何你能想象到的场景,无论是现实中难以抵达的冰川、火山,还是充满想象力的科幻空间或魔法森林,极大丰富了品牌视觉表达,生成的超现实场景。可以为品牌创造独一无二的视觉冲击力,非常适合用于品牌形象宣传片、社交媒体的病毒式营销。对于一些前卫的、概念性的服装设计,用AI制作复杂超现实场景,成本极低、极具表现力,甚至可以上升到概念性的层级。

动态视频与直播:

全天候运营: 之前的AI数字人可以7天24小时不间断直播,覆盖所有时区的用户,在非黄金时段,使用AI主播进行不间断的商品轮播和基础问答,承接流量。不错过任何潜在的销售机会。而现在,对于服装来说,也可以复刻一样的打法,甚至比数字人简单,当然也有很大的不同,通过不同的动态展示,视频和直播能够有效拉低成本,正式化建模则保证客户所看即所得,而不是卖家秀和买家秀。

全息应用:

全息的意义在于打破次元壁,创造线下沉浸式体验。很适合新零售与线下引流场景,比如在商场或品牌旗舰店,使用全息设备展示AI模特穿着主打款式的吸睛橱窗,可以极大地吸引顾客驻足,提升进店率。也可以设置虚拟模特接待员: 在发布会、展览等场合,迎宾,提供充满科技感的体验。舞台与活动上,提供真实又震撼的效果。对于服装行业来说,从各个角度展示服饰的细节。无论是裙摆的飘逸、衣领的立体,还是袖口的精致,服饰的优点都一览无余,极大地提升了购物的体验

全息场景下Ai服装细节栩栩如生

AIGC技术的升级与发展

要实现以上功能的完美展示,需要技术上的升级,难度要点如下:

硬件成本——对于全息技术,还包括改造场地的成本。还有内容制作的门槛,目前只有专业的技术设计团队能做到。

Stable Video Diffusion

AnimateDiff / Stable Video Diffusion (SVD): 这类技术可以在不改变人物和背景的情况下,让静态图片中的人物产生自然的、连贯的微小动作(如眨眼、微笑、头部轻微转动、呼吸感)。这是实现“动态写真”或直播间中最基础的“待机动画”的核心。

还要目前为止最强大的文生视频模型 (如 Sora, Kling, Vidu): 里面不仅有大语音模型的文字理解能力,大图片模型的图片识别能力,还要有真实物流引擎对真实物理世界的训练学习,以制作真实的场景感。虽然Sora等模型效果惊艳,但目前要生成一段完全符合商业要求、细节精准的长视频仍然有难度,稳定性(如人物一致性、物理交互的准确性)是主要挑战,这需要高质量的调试,成本不菲。

实时驱动技术 (Live Streaming / Real-time Animation): 这是实现AI模特直播间最核心、也是最复杂的技术。它通常结合了多种技术:

动作捕捉: 通过摄像头捕捉真人的动作和表情,实时映射到AI模特身上。这需要用到面部关键点识别和人体姿态估计技术。

实时渲染: 使用游戏引擎(如Unreal Engine 5)或专门的渲染软件,将AI模特的模型与捕捉到的动作结合,并进行实时光影渲染,保证直播画面的流畅和真实感。

整合直播流: 将渲染出的动态画面与TTS生成的语音结合,推送到直播平台。

复杂场景、走秀与全息的实现

这是将AI模特应用推向极致的想象,涉及更复杂的场景融合与输出形式。

复杂场景与走秀:

实现方式: 这部分主要依赖于强大的视频生成模型和3D渲染技术。

AI视频生成: 使用Sora级别的模型,理论上可以直接生成AI模特在复杂场景(如科幻城市、热带雨林)中走秀的完整视频。模型的关键在于对物理世界交互和长镜头连贯性的理解。

游戏引擎/CG技术: 更传统也更可控的方式是,在Unreal Engine 5或Blender等3D软件中创建出逼真的走秀场景和T台,然后将创建好的AI模特3D模型放入场景中,通过动画K帧或动作捕捉来制作走秀动画,最终渲染出影视级别的视频。这种方式成本高,但效果和可控性最好。

总结与展望

| 应用场景 | 核心实现技术 | 目前成熟度 | 未来趋势 |

| 静态写真/三视图 | Stable Diffusion + ControlNet + LoRA | 非常成熟,已广泛应用 | 更高的真实感,更简便的控制 |

| 动态写真/短视频 | AnimateDiff, SVD, RunwayML, Pika | 发展迅速,效果越来越好 | 更长的生成时间,更复杂的动作 |

| AI模特直播间 | 视频轮播 / 实时动捕+渲染 / LLM+TTS | 成本和技术门槛差异大,低端已普及 | 结合大语言模型实现自主交互 |

| 复杂场景/走秀视频 | Sora类文生视频模型 / 游戏引擎CG制作 | 技术前沿,尚未普及 | AI直接生成电影级长片 |

| 全息展示 | AI生成视频源 + 全息硬件设备 | 成熟,但受限于硬件成本和场地 | 更逼真的裸眼3D效果,与AR/VR结合 |

总的来说,从一张静态的AI模特写真,到超越现实的场景及全息AI模特秀,我们正在经历一个从“生成”到“驱动”,再到“实时交互”的技术演进过程。包含3D建模、动态视频、语音技术、全息技术乃至实时交互应用的多个层面,是当前AI生成内容(AIGC)领域非常前沿和热门的方向。目前,静态和基础动态的应用已经相对成熟,而能够进行复杂交互、实时生成高质量动态内容的AI模特,将是大语言模型、计算机视觉和图形学等领域深度融合的未来方向。